Nell’attuale scenario educativo, si analizza come il pensiero di Luca Gervasutti rappresenti una guida autorevole per integrare l’intelligenza artificiale nella scuola, promuovendo una governance consapevole e responsabile. Questo approccio si applica a dirigenti, insegnanti e policy makers che desiderano affrontare con profondità e responsabilità i cambiamenti culturali e pedagogici derivanti dall’uso dell’IA.

- Approccio pedagogico e etico all’intelligenza artificiale

- Ruolo della scuola come soggetto attivo e responsabile

- Normative e responsabilità condivise nella gestione dell’IA

- Importanza di una governance basata su principi di misura e discernimento

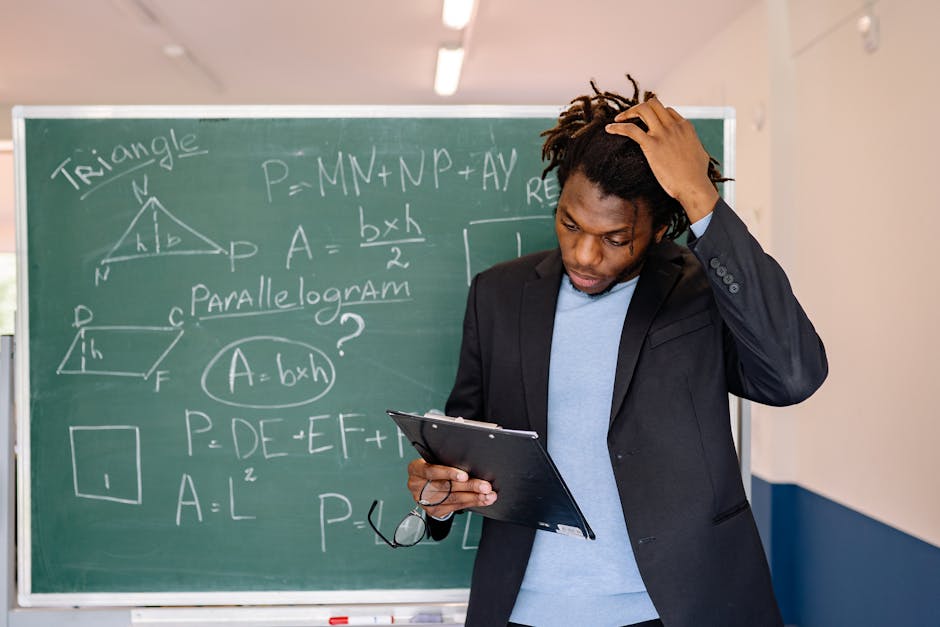

- Il ruolo centrale dell’insegnante come filtro critico e interpretativo

Il pensiero di Luca Gervasutti sull’uso responsabile dell’intelligenza artificiale

Il pensiero di Luca Gervasutti sull’uso responsabile dell’intelligenza artificiale si fonda sull’importanza di un approccio equilibrato e consapevole, capace di guidare l’intera comunità educativa verso un'integrazione etica e efficace. Egli sottolinea come sia fondamentale non solo adottare le innovazioni tecnologiche, ma farlo seguendo un principio di pensare l’intelligenza artificiale come uno strumento al servizio dell’apprendimento e dello sviluppo umano, piuttosto che come fine in sé. Secondo Gervasutti, il ruolo della scuola non è più solo quello di trasmettere conoscenze, ma di diventare un centro di pensiero critico e di governo delle tecnologie emergenti, creando una cultura digitale che sia rispettosa dei valori etici e delle diversità. Innovare senza perdere di vista l’etica significa quindi promuovere un uso dell’IA che potenzi le capacità degli studenti, sostenga i docenti e favorisca un dialogo aperto e responsabile sulla sua applicazione. In questa prospettiva, la scuola deve assumere un ruolo di leadership nel governare questa trasformazione, formando figure professionali capaci di valutare criticamente le opportunità e i rischi dell’intelligenza artificiale, garantendo così un progresso sostenibile e inclusivo per tutti gli attori coinvolti.

Visione pedagogica e etica dell’IA

Inoltre, Luca Gervasutti sottolinea l'importanza di sviluppare una visione pedagogica che integri l’uso dell’intelligenza artificiale in modo critico e consapevole, stimolando nei giovani una capacità di riflessione sulle implicazioni etiche e sociali di questa tecnologia. Per lui, pensare l’intelligenza artificiale significa anche educare le nuove generazioni a essere cittadini digitali responsabili, capacitando gli studenti a comprendere i limiti e i rischi associati all’uso dell’IA, ma anche le opportunità che può offrire. La sua proposta pedagogica si basa sulla promozione di competenze trasversali come il pensiero critico, l’etica e la collaborazione, fondamentali per governare con responsabilità l’integrazione dell’intelligenza artificiale nel contesto scolastico. Gervasutti insiste sulla necessità di una formazione docente che prepari gli insegnanti non solo all’utilizzo delle tecnologie, ma anche alla loro gestione etica, ponendo l’accento sulla responsabilità educativa di accompagnare gli studenti in un percorso di esplorazione consapevole del digitale. In questo modo, la scuola diventa un luogo di promozione di valori morali e civici, in grado di formare cittadini capaci di utilizzare l’IA come uno strumento di crescita e di solidarietà sociale, piuttosto che di dipendenza o di esclusione. La sua visione pedagogica si configura quindi come un ideale equilibrio tra innovazione e etica, volto a governare il progresso tecnologico in direzione di un progresso umano e culturale sostenibile.

Il principio della misura come guida al governo dell’IA

Il principio della misura rappresenta un elemento chiave nel pensiero di Luca Gervasutti, riconoscendolo come fondamentale per il governo etico e responsabile dell’intelligenza artificiale nel contesto scolastico e più in generale. In un’epoca in cui le innovazioni tecnologiche avanzano rapidamente, adottare una prospettiva basata sulla misura significa valutare con attenzione l’impatto di tali strumenti, evitando derive impulsive che possano compromettere valori fondamentali come la privacy, l’autonomia e la dignità degli individui.

Questo principio invita insegnanti, governi e sviluppatori di IA a stabilire limiti chiari e criteri condivisi per l’uso delle tecnologie, favorendo un approccio che metta al centro l’etica e la responsabilità. In ambito educativo, in particolare, la misura si traduce nella capacità di integrare l’IA in modo efficace senza sacrificare il ruolo critico dell’educatore, promuovendo un ambiente in cui gli studenti imparano a distinguere tra innovazione utile e rischio, sviluppando autonomia di pensiero e senso critico.

Governare l’IA con la misura significa quindi creare un equilibrio tra il desiderio di progresso e la necessità di salvaguardare valori umani imprescindibili. Questo approccio consente di sperimentare nuove metodologie didattiche e strumenti tecnologici all’interno di un quadro di responsabilità condivisa, contribuendo a formare cittadini consapevoli e capaci di affrontare le sfide di un mondo sempre più digitalizzato. In questo modo, Luca Gervasutti sottolinea come il pensiero educativo contemporaneo non possa prescindere dall’applicazione di un principio di misura quale guida imprescindibile per un futuro sostenibile e giusto.

Potenza e coscienza: il limite umano nell’era dell’IA

Inoltre, Gervasutti evidenzia come la sfida principale consiste nel trovare un equilibrio tra l’utilizzo delle potenzialità dell’intelligenza artificiale e il rispetto delle qualità proprie dell’educazione umana. La tecnologia può supportare e arricchire le modalità di insegnamento, ma non può sostituire la capacità degli insegnanti di creare relazioni significative, di comprendere le emozioni e i bisogni dei studenti, e di sviluppare il pensiero critico. Per governare efficacemente la scuola nell’era dell’IA, è fondamentale mantenere questa distinzione, investendo nella formazione di insegnanti capaci di integrare le nuove tecnologie senza perdere di vista il valore insostituibile della dimensione umana e della coscienza educativa.

Sorveglianza umana e cultura responsabile

Il controllo dell’uso dell’IA richiede una sorveglianza umana, intesa come presidio culturale e responsabilità condivisa. Ogni decisione tecnologica deve essere vigilata da dirigenti e comunità scolastica, garantendo trasparenza, responsabilità e rispetto della dignità degli studenti e del staff.

Normative e responsabilità nel governo dell’IA in ambito scolastico

Per Gervasutti, le norme come il GDPR e l’AI Act rappresentano più che semplici vincoli formali: sono strumenti per promuovere una cultura della responsabilità educativa. Interpretare queste normative come opportunità di formazione significa pensare alla conformità non come un adempimento burocratico, ma come parte integrante di un percorso di cittadinanza digitale responsabile e consapevole.

Il ruolo del regolamento d’istituto come patto sociale

Il regolamento d’istituto, in questa ottica, diventa un vero e proprio patto di responsabilità condivisa, coinvolgendo tutta la comunità scolastica in un processo partecipato di definizione delle pratiche digitali. La sua redazione deve basarsi su trasparenza, motivazione e senso di appartenenza, favorendo l’adozione responsabile delle tecnologie.

Responsabilità educativa e partecipazione collettiva

Il documento rappresenta uno strumento di governo culturale, capace di rafforzare la responsabilità pedagogica di ciascuno e di favorire una cultura della digitalizzazione consapevole. La partecipazione attiva e trasparente costituisce la chiave per una governance efficace e condivisa.

Impatto sul ruolo dei docenti

L’autore insiste sulla funzione critica del docente, che deve interpretare, selezionare e orientare l’uso dell’IA, mantenendo una funzione di filtro tra tecnologia e significato pedagogico. Ogni insegnante diventa un mediatore di senso e un tutore della responsabilità educativa.

Discorso sui valori: discernimento e lentezza

Gervasutti promuove valori come la lentezza e il discernimento, fondamentale opposto alle logiche dell’instantaneità digitale. La scuola deve custodire il tempo del pensiero, favorendo un’approfondita maturità critica e un’educazione basata sul valore della riflessione.

Governance operativa e cultura scolastica

Un’efficace governance dell’IA richiede strumenti organizzativi chiari, condivisi e tracciabili, coinvolgendo tutti i livelli dell’istituzione scolastica. La progettazione di processi trasparenti e condivisi permette di mantenere saldo il rapporto tra innovazione e principi pedagogici, puntando alla coerenza tra pratiche e valori.

Ruoli e responsabilità condivise

La gestione dell’IA dev’essere radicata su scelte precise, con responsabilità distribuite tra dirigente, docenti e comunità. La formazione continua, la trasparenza e la documentazione sono elementi fondamentali per una governance efficace e duratura.

Integrazione nel modello scolastico

Il modello proposto da Gervasutti è equilibrato: innovativo senza perdere di vista l’identità educativa. La scuola deve essere un soggetto responsabile capace di governare il cambiamento mantenendo fede ai propri valori, promuovendo un’innovazione sostenibile e condivisa.

Conclusioni

Il pensiero di Luca Gervasutti rappresenta una proposta matura e profondamente etica per pensare e governare l’intelligenza artificiale nella scuola. La sua visione, che unisce teoria, pratica e valori, fornisce una strada sicura per costruire una governance educativa umana, responsabile e sostenibile in tempi di rapido sviluppo tecnologico.

FAQs

Pensare l’intelligenza artificiale, governare la scuola: Luca Gervasutti come eccellenza del pensiero educativo contemporaneo — approfondimento e guida

Gervasutti vede l'IA come uno strumento da integrare in modo etico e consapevole, promuovendo il pensiero critico e la responsabilità educativa per un progresso sostenibile.

Gervasutti sottolinea l'importanza di una governance basata su principi di misura, discernimento e responsabilità condivisa per garantire un uso dell’IA rispettoso dei valori umani e etici.

Lo vede come un filtro critico e interpretativo, che media tra tecnologia e pedagogia, assumendo un ruolo fondamentale nella formazione etica e critica degli studenti.

Sostenendo l’importanza di un'educazione alle implicazioni etiche e sociali dell’IA, promuovendo competenze come il pensiero critico, l’etica e la collaborazione tra gli studenti.

È un elemento chiave che guida la valutazione etica dell’uso dell’IA, indicando limiti chiari e criteri condivisi per favorire un progresso responsabile e rispettoso dei valori fondamentali.

Ricorda che la tecnologia supporta ma non può sostituire la capacità umana di creare relazioni significative, comprendere le emozioni e sviluppare un pensiero critico, mantenendo il valore della coscienza educativa.

La sorveglianza umana rappresenta un presidio culturale e etico, garantendo trasparenza, responsabilità e rispetto dei diritti degli studenti e del personale scolastico.

Le considera strumenti per promuovere una cultura di responsabilità educativa, interpretandole come opportunità di formazione verso una cittadinanza digitale consapevole.

Diventa un patto di responsabilità condivisa, coinvolgendo tutta la comunità scolastica e promuovendo pratiche digitali trasparenti e motivate.

Favorendo la trasparenza, la partecipazione attiva di insegnanti e studenti e sostenendo una cultura di responsabilità condivisa nel processo decisionale.